SiFive 博客

来自 RISC-V 专家的最新洞察与深度技术解析

本地 AI 的完美解决方案

全新 X100 系列,SiFive Intelligence 系列第二代成员

近年来,AI 一直是科技行业的焦点。随着 RISC-V 的快速发展,SiFive 通过我们的 Intelligence IP 家族取得了领先地位,提供了一个基于单一 ISA 的可扩展计算平台,并具备根据特定 AI 工作负载进行定制的能力。

我们经常收到客户的需求,就是希望能把 AI 能力从云端移到工厂、家庭、办公室,乃至人们手中——让 AI 本地化。他们之所以有这样的需求,主要有几个原因。首先,在本地处理数据可以实现更快的响应,使人与设备的交互更加自然。其次,这也有助于保障数据的隐私和安全——如果数据从未离开本地设备,就更容易掌握谁在访问以及他们如何使用数据。随着我们越来越依赖这项技术,确保它在网络连接或基础设施不可用时依然能稳定运行,也变得尤为重要。 然而,要实现这一点并非易事。AI 通常需要大量数据和高强度的计算能力,而现有的嵌入式处理器往往难以满足所需的数据处理性能;另一方面,受成本与功耗限制,这些设备又无法采用专为数据中心设计的高性能 CPU。SiFive 的全新 X100 系列通过几个关键方面可以解决这些挑战。

首先,我们将应用在 X200 和 X300 系列上的向量引擎进行了缩减,使其能够满足严格的成本和功耗限制,同时仍然提供足以支持众多边缘 AI 推理场景的数据处理性能。RISC-V 向量 ISA 以及一系列巧妙的实现特性,造就了灵活的向量引擎,即便在低成本、高延迟的存储环境下,也能很好地应对这些挑战。 这些特性结合在一起,使得基于 SiFive X160 的设计在执行许多 AI 推理任务时,速度超过 Arm™ Cortex®-M85 的两倍,而硅片面积却是相同的。

图 1:SiFive Intelligence X160 在典型 AI 任务中的性能对比

图 1:SiFive Intelligence X160 在典型 AI 任务中的性能对比

不过,也有一些边缘 AI 任务需要更高性能,而要在边缘设备的成本和功耗预算内实现这一点,就必须引入定制加速器。这样客户就能在最小的面积和功耗约束下,打造出正好符合目标任务需求的计算配置。然而,将这些加速器集成到复杂的计算子系统中,在硬件和软件层面都可能面临困难和效率问题。为了简化这一过程并提升效率,我们提供了两种不同的与内核直连的协处理器接口,可以单独或结合使用,取决于最终应用的需求。这让 X100 系列能够作为加速器控制单元 (ACU) 来使用,承担起与客户定制加速器进行细致协作和管理的角色。

虽然 X100 系列才刚推出,但已有不少客户积极将其集成到系统中,以利用其无与伦比的 AI 效率。其中包括两家美国大型半导体公司:一家利用 X160 的向量性能驱动下一代边缘 AI SoC,另一家则使用 X160 来控制并协助其自研的 AI 加速器。

除了 X160,我们还发布了 X180。这款 Intelligence IP 实现了 64 位 RV64I ISA,具备更大的物理地址空间,非常适合与更大型的 CPU 一起在复杂 SoC 中协作。

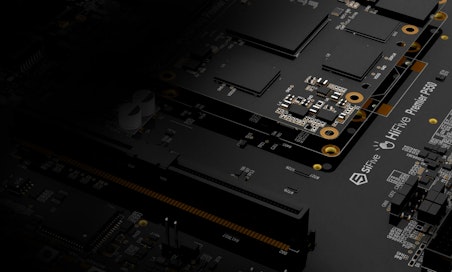

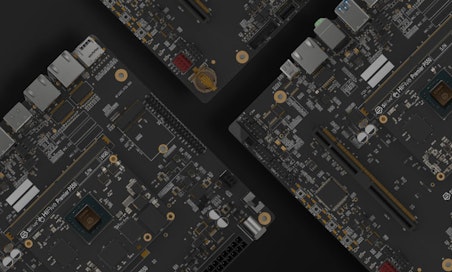

图 2:SiFive Intelligence X100 系列产品:X160 与 X180

这些新产品非常适合支持本地 AI、边缘推理,以及深度嵌入式远端场景下的向量处理。若想进一步了解这些产品、查看规格,或阅读客户/行业应用案例,请访问 Intelligence 网页,并下载 X160、X180 以及 Intelligence 系列的产品简介。

如果您正在研发本地 AI 解决方案,并想探索这些或其他 SiFive 产品是否适合您的项目,请联系 SiFive 销售团队。